为什么英伟达、AWS、阿里都喜欢Arm的服务器CPU?

耕耘多年后,基于Arm架构的CPU在服务器市场迎来了大幅增长,被众多客户喜欢并采用。

超大规模云服务商如亚马逊云服务 (AWS)、阿里巴巴、微软等自研CPU,都选择和Arm合作,这是为什么?

“答案非常简单,通过和Arm合作,他们能够根据自己的用例和基础设施来打造并优化解决方案。”Arm高级副总裁兼基础设施事业部总经理Mohamed Awad在2023 Arm Tech Symposia年度技术大会上表示。

与超大规模云服务商同样喜欢Arm服务器CPU可定制化特性的还有最重要的AI芯片提供商之一——英伟达。

在英伟达强大的GH200超级芯片中,包含了72颗Arm Neoverse核心,加上英伟达的GPU,GH200的AI性能较基于x86架构的系统可提升10倍。

为了满足更多客户在基础设施建设中的定制化需求,Arm还有两个重要举措。

为什么首选Arm Neoverse CPU?

GH200 Grace Hopper 超级芯片平台是英伟达今年5月发布的产品,专为处理海量的生成式AI任务而设计。拥有256个GH200超级芯片的NVIDIA DGX GH200超级计算机,其AI性能提升到了惊人的Exaflop(每秒一百万万亿次次算)级别。

如此强大的AI性能,关键在于系统架构的变革。

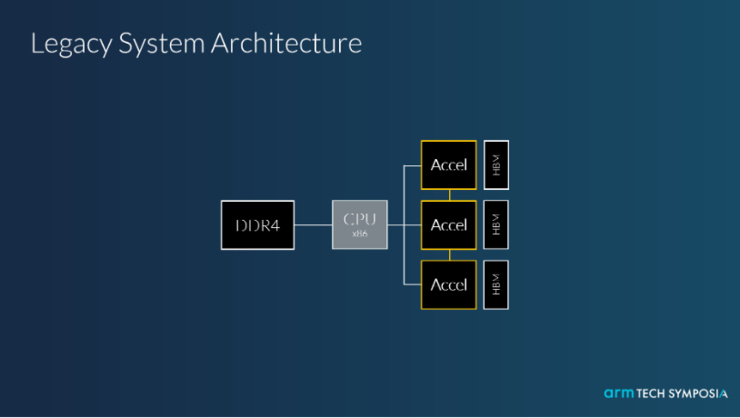

基础设施领域的传统系统架构

传统的服务器系统架构,内存通过PCIe,连接一个通用现成的CPU(也就是Host CPU),负责管理多个加速器。

“这种传统架构是过去市场上唯一可用的架构。”Mohamed Awad指出,“这个架构的问题在于,通用现成的CPU以及加速器之间的接口直接限制了产品最终的性能水平。因为所有的加速器都必须通过这个通用现成的CPU访问额外的内存,无法达到内存的一致性,加速器的性能无法被充分利用,也就无法很好地支持生成式AI的需求。”

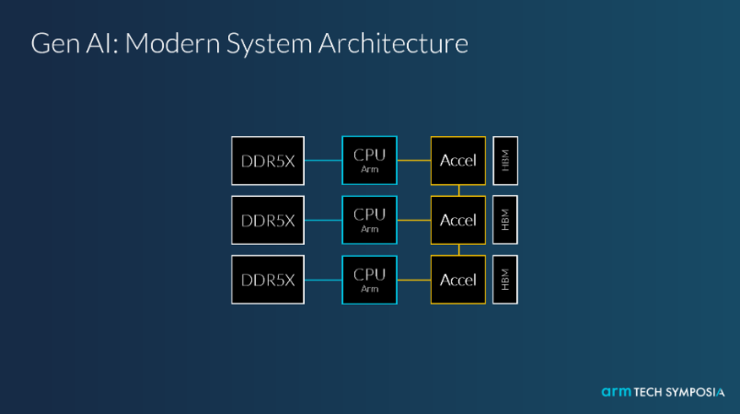

面向新的应用需求,基础设施领域出现了现代化的系统架构

GH200超级芯片改变了传统架构,通过NVLink,让每一个CPU都单独和一个加速器相连,实现较强的内存一致性。其中的关键点之一就是可客制化的 CPU,为此,借助这样的架构,英伟达能够充分发挥GPU的效率,根据实际场景和用例实现了性能的最大化。

“只有了解最终用例,并且根据使用场景针对性地设计CPU,才能获得更好的效率,达到产品最佳的表现性能。”Mohamed Awad进一步表示,“英伟达携手Arm,借助了Arm技术带来的灵活性,设计出他们所需要的芯片以进一步优化系统,同时充分利用Arm强大的软件生态系统。”

接下来的问题是,英伟达提出的这种架构会成为生成式AI时代的主流吗?

“现在判断一个CPU对一个 GPU 作为加速器是不是未来的主趋势,或唯一趋势,仍为时尚早。”Mohamed Awad对雷峰网表示,“我们正处于计算加速的时代,在未来的架构当中,不管通过什么方式耦合,任何的通用CPU旁边都一定会有一个加速器。Arm的独特之处在于,能够帮助合作伙伴从头开始、根据所需构建定制化的 CPU,做好CPU和加速器之间的连接。”

由于x86提供的是标准的CPU芯片,所以GH200超级芯片平台中CPU最佳的选择只有Arm CPU,这也是Arm Neoverse受到欢迎的关键。

也就是说,标准化的CPU不能满足基础设施的定制化需求,可定制化成了Arm在服务器市场的杀手锏。

可定制化,Arm在服务器市场的「杀手锏」

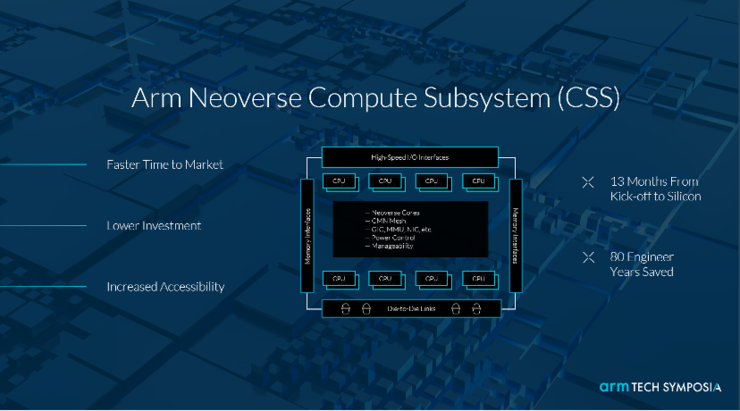

今年八月,Arm推出了Arm Neoverse计算子系统 (CSS),促使Arm生态系统通过更低的成本、更少的风险以及更短的时间,打造出专用芯片。

Arm CSS的第一代产品Arm Neoverse CSS N2集成了Neoverse N2 平台,并通过验证配置且优化了功耗、性能与面积 (PPA)。

“通过Neoverse CSS能够帮助我们的合作伙伴进一步降低投资,加速整个生态系统对我们解决方案的可访问性,同时加速合作伙伴产品的上市时间。”Mohamed Awad表示。